musaraña óptica

Hey gente,

Tengo el escritorio de Power Bi y una fuente de datos de Azure SQL que contiene 450 millones de filas de datos. Cuando cargo los datos en el escritorio o uso Direct Query, el tiempo que lleva no es razonable.

La única forma en que podría ver una mejora es si hago algo de lo siguiente:

- Reducir mi conjunto de datos (esto no es preferible debido a los datos sobre los que se informa)

- Aumente la cantidad de DTU en mi servidor SQL (el gasto no es algo que quiera soportar)

¿Estoy usando el producto adecuado para lo que quiero hacer o debo usar algo más de la pila de Microsoft?

Gracias,

j

musaraña óptica

@v-yuezhe-msft

Descubrí que si cargo por CSV en Azure Data Lake Store, puedo usar Azure Data Lake Analytics para elegir los datos que necesito y enviarlos a un nuevo CSV. Este nuevo CSV debe estar por debajo del límite de 1 GB y, por lo tanto, puedo usar ADLS como mi fuente de datos de Power Bi.

Si se alcanza el límite de 1 GB, puedo dividir el CSV e importarlos por separado combinándolos en Power Bi.

Gracias por la ayuda,

j

musaraña óptica

@v-yuezhe-msft

Descubrí que si cargo por CSV en Azure Data Lake Store, puedo usar Azure Data Lake Analytics para elegir los datos que necesito y enviarlos a un nuevo CSV. Este nuevo CSV debe estar por debajo del límite de 1 GB y, por lo tanto, puedo usar ADLS como mi fuente de datos de Power Bi.

Si se alcanza el límite de 1 GB, puedo dividir el CSV e importarlos por separado combinándolos en Power Bi.

Gracias por la ayuda,

j

kotvir

En respuesta a musaraña óptica

No es útil cuando necesita análisis en tiempo real y su modo de consulta es «Consulta directa»

La solución potencial que uno debe buscar es reducir el tamaño del conjunto de datos que PowerBI utiliza para cargar el conjunto inicial de filas a 10 o 100 y luego dejar que el usuario final decida el conjunto de registros que realmente necesita en función de sus necesidades de generación de informes (restringiendo los datos a través de un filtro o otros medios).

Nammy_shah123

En respuesta a kotvir

Hola ,

Espero que estés bien.

Dado que tengo el mismo escenario donde más de 1 millón de registros necesitan obtener y crear el informe. Entonces, en tiempo real, me gustaría saber si power Bi es una buena solución para eso. En caso negativo, ¿cuál sería la solución o herramienta para esto?

Gracias y Saludos.

musaraña óptica

En respuesta a kotvir

Hola @kotvir

Estoy de acuerdo y en desacuerdo contigo 🙂

Entonces, sí, esto no sería bueno para la transmisión de datos, simplemente no funcionaría. Idealmente, desearía crear un conjunto de datos de transmisión y abordar toda la situación de manera diferente.

Sin embargo, en el escenario, estoy viendo datos estáticos que cambian con poca frecuencia y usaré «Importar». Además, el conjunto de datos que estamos usando contiene toda la información que necesitamos donde necesitamos ver el conjunto de datos en su totalidad. Básicamente, estamos analizando las granjas de servidores de SharePoint y necesitamos comprender la distribución de tipos de archivos en ellas. Luego necesitamos la capacidad de profundizar en un servidor, unidad, archivo, etc.

Gracias,

Arrendajo

prabhuss

En respuesta a musaraña óptica

cualquier respuesta final para esto. también estoy enfrentando el mismo problema

rebin40

En respuesta a prabhuss

Tengo el mismo problema.

Mi conjunto de datos supera los 7 millones de filas y power bi funciona muy lentamente.

¿Algún consejo?

Anónimo

En respuesta a rebin40

He visto un buen desempeño con más de 40 millones de registros. ¿Cuántas tablas está importando y cuántas columnas en cada una? Aprovechar el modelo relacional de Power BI para reducir el recuento de columnas en tablas con una gran cantidad de registros ayuda en mi experiencia.

rebin40

En respuesta a Anónimo

Finalmente lo resolví usando DirectQuery

v-yuezhe-msft

@opticshrew,

En el modo DirectQuery, no debería tener problemas para conectarse a la base de datos de Azure SQL, ya que en este caso los datos no se importan al modelo de Power BI. Pero hay un límite de 1 millón de filas para devolver datos al usar DirectQuery, puede obtener más detalles en este artículo.

Por ejemplo, puede agregar 10 millones de filas con su consulta que se ejecuta en el origen de datos y devolver con precisión los resultados de esa agregación a Power BI mediante DirectQuery, siempre que los datos devueltos a Power BI tengan menos de 1 millón de filas. Si DirectQuery devuelve más de 1 millón de filas, Power BI devuelve un error.

Además, en el modo de importación, ¿cuánto se tarda en importar datos de Azure SQL a Power BI Desktop? Le recomendaría crear una vista para agregar los datos que necesita e importar la vista a Power BI, y puede consultar el siguiente blog sobre otras prácticas recomendadas.

https://www.sqlbi.com/articles/data-import-best-practices-in-power-bi/

Saludos,

lidia

musaraña óptica

En respuesta a v-yuezhe-msft

@v-yuezhe-msft

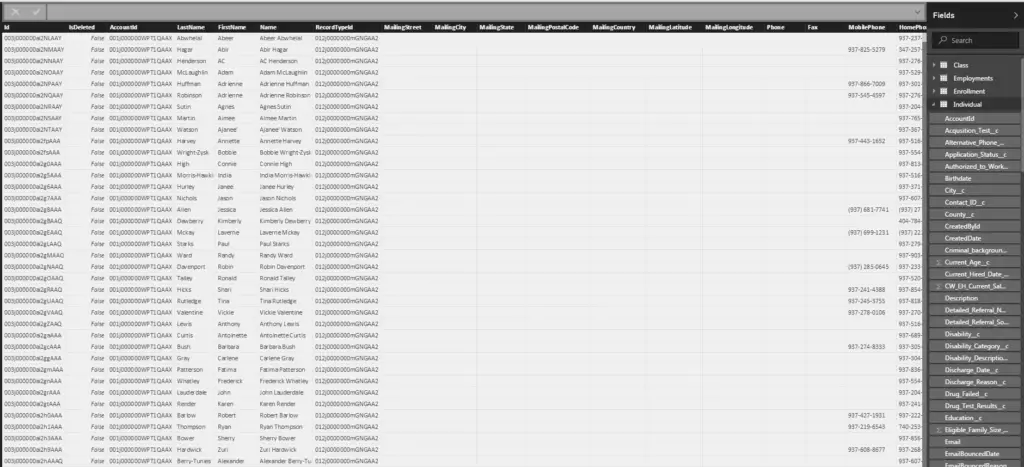

No siento que voy a poder agregar los datos, aquí hay un ejemplo de lo que está pasando:

FilePath AccessTime WriteTime C:FilePathA 01/01/2018 10:00 AM 01/01/2018 10:00 AM

Los datos se cargan en la base de datos SQL desde el almacenamiento de blobs. Cada blob es un CSV que contiene aproximadamente 1 millón de líneas. Luego se cargan en SQL, donde se les asignan los tipos de datos de columna correctos. * tenga en cuenta que FilePath es diferente cada vez *

En cuanto al tiempo de carga, actualmente no tenemos 450 millones de filas de datos, sin embargo, esto es lo que debemos planificar. Actualmente, con alrededor de 200 000 filas de datos, está mirando alrededor de 20 a 30 minutos.

¿Diría que es mejor crear un informe exclusivamente por CSV?

Gracias,

j