davidbrown100

actualmente tenemos una puerta de enlace local de powerbi alojada en aws ec2 t2.large que tiene 2 vcpu y 8 gb de ram.

sin embargo, al actualizar un informe, tenemos problemas de memoria.

una tabla tiene 57 millones de registros.

¿Alguien tiene alguna experiencia en dimensionar la puerta de enlace en ec2, antes de decidir ir a t2.xlarge 4 vcpu y 16 gb de ram?

RMDNA

En respuesta a davidbrown100

@davidbrown100,

Creo que el problema está en las especificaciones del sistema. 2 CPU virtuales y 8 GB de RAM son muy muy bajo cuando se trata de grandes conjuntos de datos. En lugar del tamaño de fila de la tabla, ¿cuántos datos totales maneja en términos de GB?

Tenemos clientes con conjuntos de datos de más de 50 GB y usamos Azure Databricks con 15 vCPU y 56 GB de RAM.

davidbrown100

Recibí un ticket de soporte con Microsoft sobre esto, pero las soluciones no funcionaron.

al final, aumenté la memoria en el servidor a 16 gb y ahora funciona bien: alcanza un máximo de alrededor de 8,3 gb

ahora estamos usando t2.xgrande.

Observaciones interesantes sobre la puerta de enlace mientras se depura el problema.

yo diría que el proceso se divide en 3

a) obtener los datos a través del conector odbc

b) mashup los datos usando el contenedor mashup

c) enviar los datos al servicio powerbi

En nuestro caso, el paso b) es la parte que requiere mucha memoria y no maneja la falta de memoria de manera muy elegante.

También recomendaría colocar la puerta de enlace lo más cerca posible de la fuente de datos, para evitar problemas de red, ya que el volumen de datos recibidos (paso a) es mucho mayor que el volumen de datos enviados (paso c)

davidbrown100

Recibí un ticket de soporte con Microsoft sobre esto, pero las soluciones no funcionaron.

al final, aumenté la memoria en el servidor a 16 gb y ahora funciona bien: alcanza un máximo de alrededor de 8,3 gb

ahora estamos usando t2.xgrande.

Observaciones interesantes sobre la puerta de enlace mientras se depura el problema.

yo diría que el proceso se divide en 3

a) obtener los datos a través del conector odbc

b) mashup los datos usando el contenedor mashup

c) enviar los datos al servicio powerbi

En nuestro caso, el paso b) es la parte que requiere mucha memoria y no maneja la falta de memoria de manera muy elegante.

También recomendaría colocar la puerta de enlace lo más cerca posible de la fuente de datos, para evitar problemas de red, ya que el volumen de datos recibidos (paso a) es mucho mayor que el volumen de datos enviados (paso c)

davidbrown100

Hola a todos, tuve tiempo de dormir sobre esto y he llegado a una solución diferente.

Nuestros datos están en corrimiento al rojo, y comenzamos usando el conector de corrimiento al rojo (no se requiere una puerta de enlace PBI). Sin embargo, existen limitaciones con respecto a cómo puede usar este conector, es decir, solo se conecta a una tabla completa.

Sí, puede aplicar filtros básicos después y parece tenerlos en cuenta en la actualización de datos.

De todos modos, necesitamos más control que esto, es decir, la capacidad de unir tablas en nuestra solicitud de datos.

Así que nos mudamos a ODBC y, a regañadientes, configuramos una puerta de enlace powerbi.

Genial, todo esto funciona, excepto por el rendimiento en grandes conjuntos de datos.

Así que ahora he intentado usar un enfoque híbrido. Aquellas tablas en las que estamos tomando todos o casi todos los datos, podemos tomarlos usando el conector redshift, y aquellas tablas donde necesitamos más control, use el conector odbc. Esto quita mucha tensión a la puerta de enlace.

Probablemente cambiaremos el tamaño de la puerta de enlace a 16 gb, dados otros comentarios anteriores, y tengo un ticket de soporte para considerar si hay algunos errores. Creo que los hay porque, por ejemplo, está pasando las mismas consultas al corrimiento al rojo dos veces.

davidbrown100

Ahora estoy más inclinado a decir que se trata de un error en la puerta de enlace local.

He notado que se solicitan consultas duplicadas a la base de datos redshift

he actualizado a la última versión de la puerta de enlace 14.16.6745.2 pero no sirvió de nada

Intenté configurar MashupDefaultPoolContainerMaxCount = 1 pero no hubo cambios.

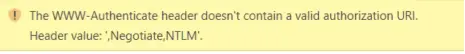

El error que estoy recibiendo es

Se lanzó una excepción de tipo ‘System.OutOfMemoryException’.

al intentar importar una tabla más grande.

RMDNA

En respuesta a davidbrown100

@davidbrown100,

Creo que el problema está en las especificaciones del sistema. 2 CPU virtuales y 8 GB de RAM son muy muy bajo cuando se trata de grandes conjuntos de datos. En lugar del tamaño de fila de la tabla, ¿cuántos datos totales maneja en términos de GB?

Tenemos clientes con conjuntos de datos de más de 50 GB y usamos Azure Databricks con 15 vCPU y 56 GB de RAM.

davidbrown100

En respuesta a RMDNA

Este informe en particular ocupa solo 175Mb. No he oído hablar de Azure Databricks antes, ¿es posible instalar una puerta de enlace local Powerbi allí?

RMDNA

En respuesta a davidbrown100

No me refería al archivo PBIX; debido a la compresión, no existe una proporción directa entre la cantidad de datos y el tamaño del archivo. Me refería a la cantidad de datos que extrae de su fuente de datos, en GB.

Databricks no es un servicio de Power BI, es una plataforma de procesamiento de datos. Solo lo estaba usando como un ejemplo de las especificaciones con las que tratamos.

davidbrown100

En respuesta a RMDNA

disculpas.

La tabla principal que estamos procesando es de 9 gb en corrimiento al rojo, y la mayoría de sus columnas están codificadas, así que supongo que dependiendo de cómo funcionen estas cosas, podría ser mayor para cuando llegue a la puerta de enlace powerbi.

Para hacer que la importación sea más manejable, la cargo en 10 importaciones separadas y luego las agrego dentro de powerbi; no estoy seguro de si es una buena idea o no.

Seth_C_Bauer

En respuesta a RMDNA

@ davidbrown100 Estoy de acuerdo con @RMDNA cualquier trabajo pesado simplemente aplasta la puerta de enlace con los métodos de importación que se utilizan. Prácticamente siempre recomendamos al menos 16 GB como punto de partida, pero puedo ver fácilmente escalar más alto como se dijo.